在采集数据的前期,我们需要为爬虫准备一个登录的代码,而且要一直保持登录,才不会被网站识别出来。这两天我们也介绍了不少的方法,但是本次我们需要达到一直保持登录的这个条件,小伙伴们有没有其他的方法能够满足条件呢?小编在学习的时候接触到了session,发现它可以让账户处于一直登陆的状态下,接下来我们一起学习session的用法吧。

有很多python的方法可以实现登陆网页,但是如果需要保持登陆条件下使用网页的某些功能,则一般需要利用cookie。在所有的实现方法中,Request包是一种相对比较简洁的方法。

import request

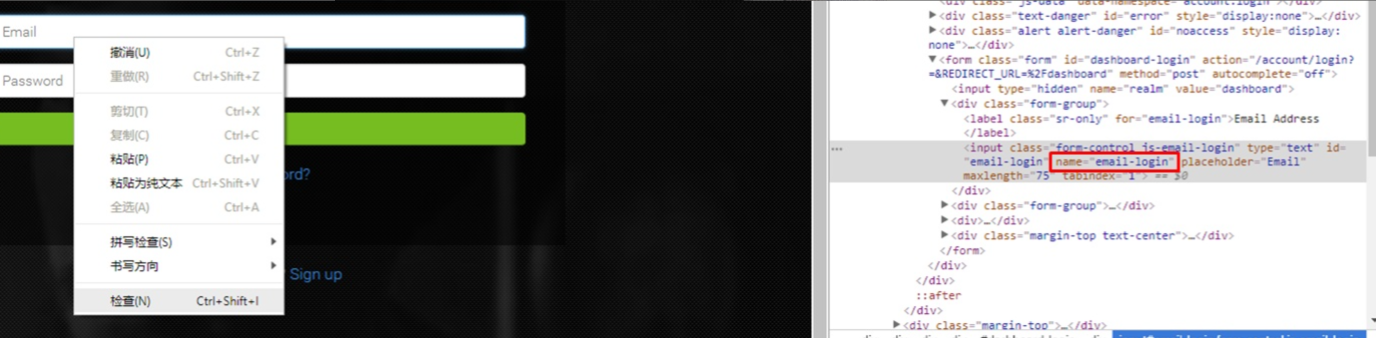

找到目标网页的登陆页面,在浏览器中用右键点击用户名和密码区域“查看网页源代码”。在高亮的代码中找name对应的值,通常是”username”, “password”。在这个例子中是”email-login” 和”password-login”。

接下来的在代码中建立一个session,保持登陆状态。

s = Session()

s = session.post("登陆页面的url",

'email-login': “用户名”,

'password': “密码”,

#'Token': "某些网站需要token,可以在这里添加"

}

之后可以继续利用s 这个session来爬取网页内容或者利用api下载文档。

只要确保完成session的建立,我们的账户就会一直处于登陆状态,当然爬虫也可以继续收集数据啦。有很多数据想要采集,但苦恼于账号不能一直保持登录的可以试试session的方法。

神龙|纯净稳定代理IP免费测试>>>>>>>>天启|企业级代理IP免费测试>>>>>>>>IPIPGO|全球住宅代理IP免费测试