文章目录

- 什么是网络爬虫

- 浏览器的工作原理

- 爬虫的工作原理

什么是网络爬虫

网络爬虫,简称爬虫,是一种按照一定的规则,自动地抓取互联网信息的程序或者脚本。

爬虫做的事情其实和蜘蛛是类似的,所以网络爬虫也被称为网络蜘蛛(spider)。蜘蛛在蜘蛛网上爬来爬去,把触手伸到蜘蛛网获取食物,而网络爬虫则是在互联网上爬来爬去,爬取我们需要的数据。

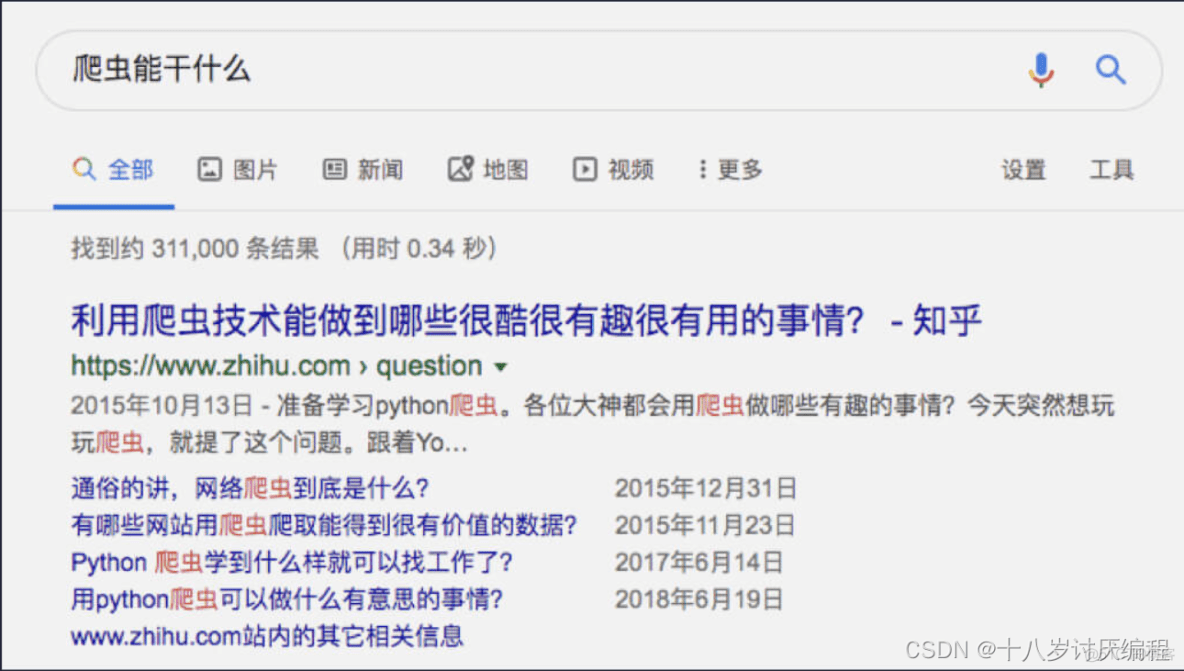

虽然你只是刚开始学习爬虫,但在生活中其实你已经在很多地方使用过爬虫了。比如当你想知道“爬虫能干什么”,于是打开搜索引擎搜索“爬虫能干什么”。搜索结果如下图所示:

搜索引擎本质上就是爬虫。在上面的过程中,搜索引擎将互联网上的网页都爬取并存储起来。当我们搜索的时候,搜索引擎就从自己存储的网页里找到我们需要的结果并展示出来。

随着机器学习、人工智能技术的发展,数据越来越重要,需要的数据量也越来越大。而我们可以通过爬虫获取海量的数据,所以爬虫是这一切的源头。

一般情况下,我们都是通过浏览器浏览网页,获得信息。所以,在说爬虫之前,我们先说说浏览器。

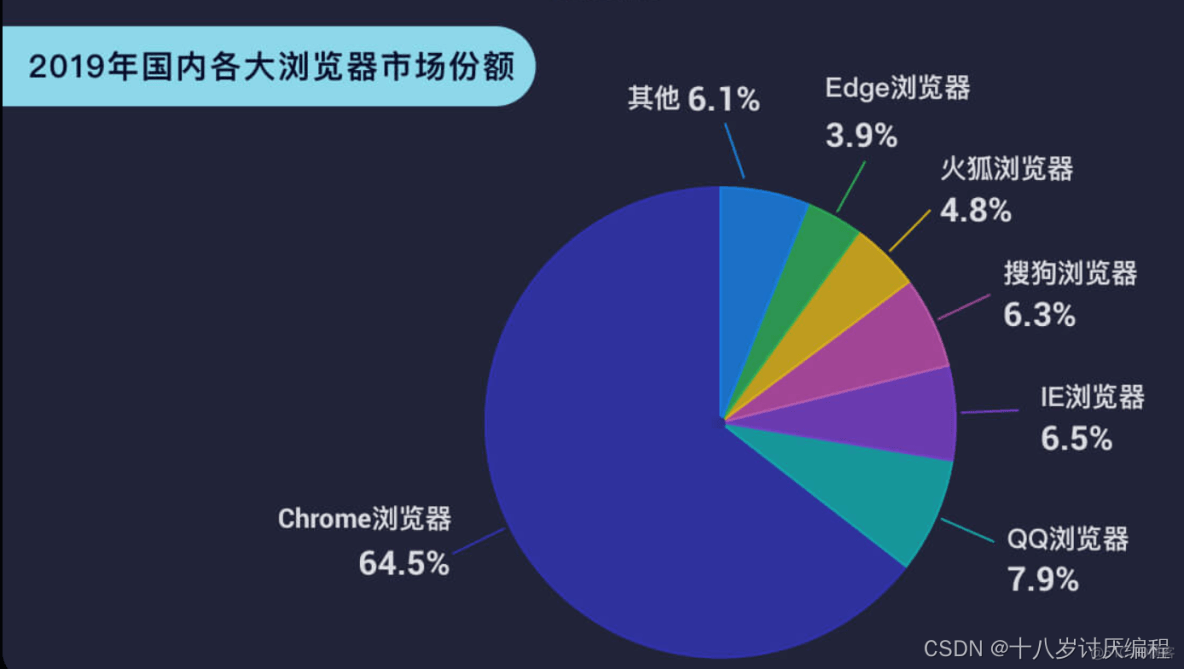

浏览器有很多种,主流的浏览器有 Chrome 浏览器、QQ 浏览器、IE 浏览器、搜狗浏览器等。

浏览器的工作原理

我们以扇贝搭建的爬虫博客平台为例,网址是:https://wpblog.x0y1.com/

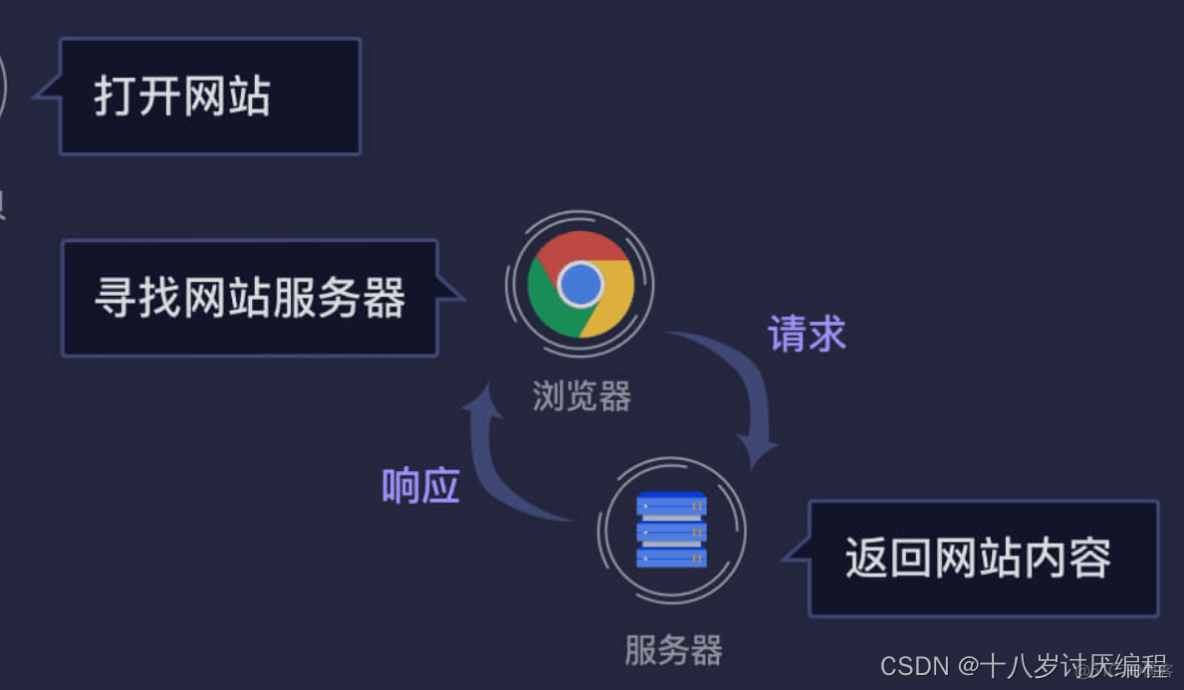

假如我们要博客里文章的数据,首先我们会输入网址,然后浏览器将网站内容展示出来。我们和浏览器的交互过程如下图所示:

那么浏览器是怎么知道扇贝编程博客网站内容的呢?难道浏览器将所有网站的内容保存下来了?

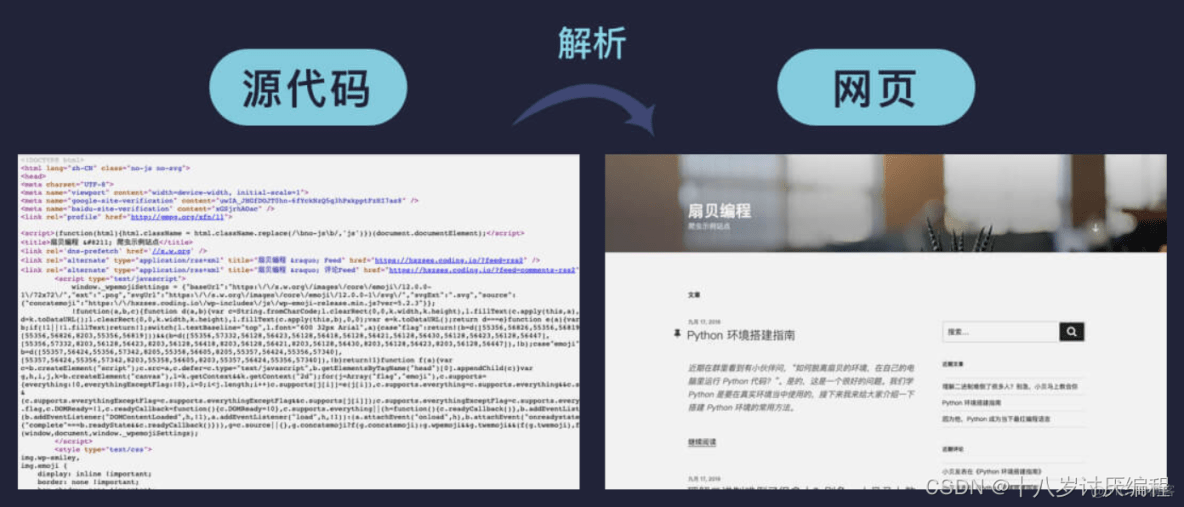

当然不是这样!其实,浏览器偷偷地和 服务器 进行了交流,服务器将博客网站的内容传输给浏览器,浏览器收到后解析成你最终看到的网页。

浏览器通过 DNS(Domain Name System)将域名转换成对应的 IP 地址,从而找到对应网站的服务器。如果你对这个过程感兴趣,可搜索 DNS 了解更多。

首先,我们在浏览器输入网址(URL)。然后浏览器去访问该网址对应的服务器,这个过程叫 请求(request)。接着服务器将网站内容发送给浏览器,这个过程叫 响应(response)。浏览器拿到服务器返回的内容后,一般都是网页的源代码。还需要浏览器将内容解析成我们能看懂的样子,也就是我们最终在浏览器里看到的网页。

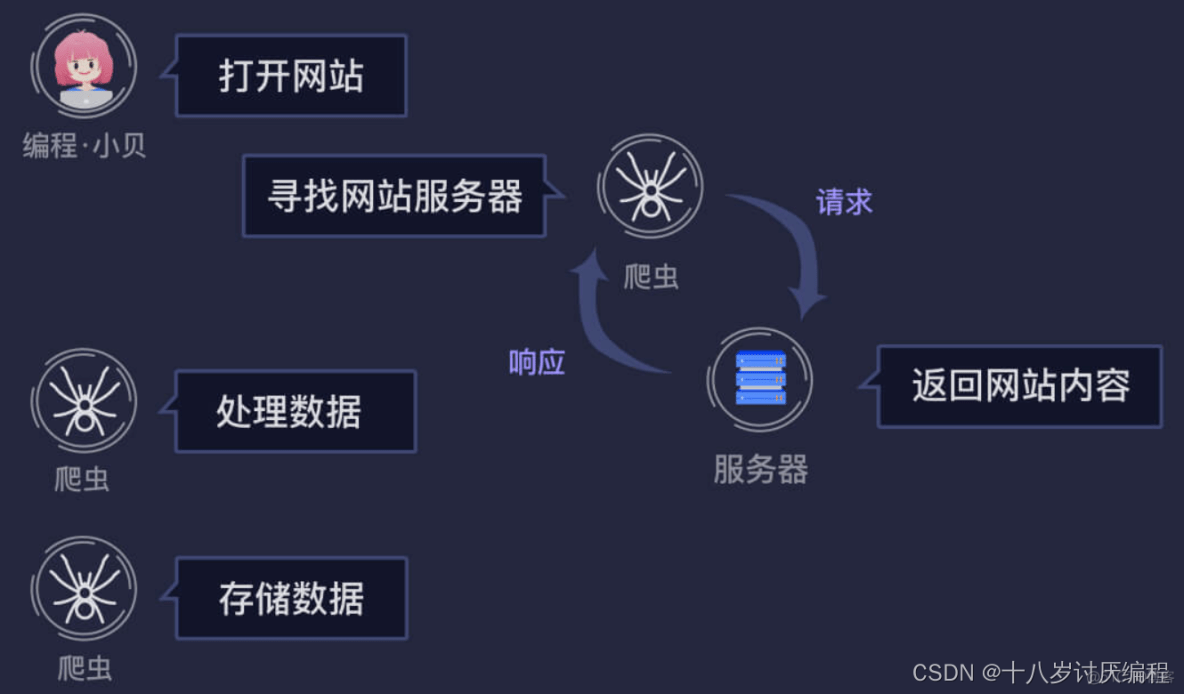

说了半天浏览器的工作原理,这和我们的爬虫有什么关系呢?其实,爬虫就是模拟浏览器的行为,从而获取网站的数据。

爬虫的工作原理

爬虫可以像浏览器一样向服务器发起请求,拿到服务器返回的数据后,可以根据我们设定的规则去提取需要的数据,数据处理完成后再将数据存储起来。

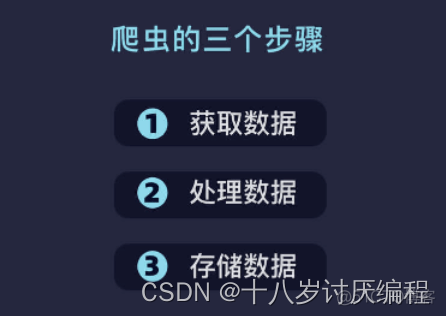

我们将上面的过程简化一下,可以将爬虫的工作总结为 3 步:

第一步:获取数据,爬虫会根据我们提供的网址,向服务器发起请求获取数据;

第二步:处理数据,对获取的数据进行处理,得到我们需要的部分;

第三步:存储数据,将处理后的数据保存起来,便于后续的使用和分析等。

神龙|纯净稳定代理IP免费测试>>>>>>>>天启|企业级代理IP免费测试>>>>>>>>IPIPGO|全球住宅代理IP免费测试