一,通用代码框架

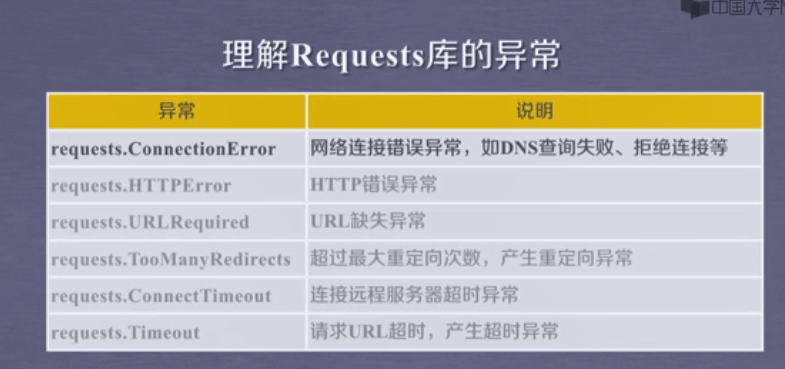

1,Requests库的异常

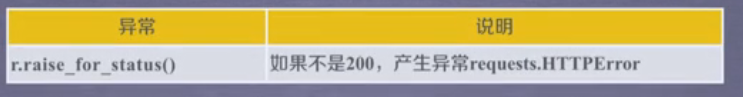

该方法能判断返回的内容是不是200,是200返回内容正确,不是就引起HTTPError

2,爬取网页的通用代码框架

import requests def getHTMLText(url): try: r=requests.get(url,timeout=30) r.raise_for_status() r.encoding=r.apparent_encoding return r.text except: return "产生异常" if __name__=="__main__": url="http://www.baidu.com" print(getHTMLText(url)) #获得相应网站的HTML代码

3,习题

编写代码实现使用通用爬虫框架实现对新浪百度搜索首页的信息获取,并将信息内容存放在文件中,注意保存前先处理内容的编码。

答案代码如下:

import requests

def getHTMLText(url):

try:

r=requests.get(url,timeout=30)

r.raise_for_status()

r.encoding=r.apparent_encoding

return r.text

except:

return "产生异常"

if __name__=="__main__":

url = "http://www.sina.com.cn/"

f = open("D:/1.txt", 'wb')

f.write(getHTMLText(url).encode('utf-8'))

f.close()

神龙|纯净稳定代理IP免费测试>>>>>>>>天启|企业级代理IP免费测试>>>>>>>>IPIPGO|全球住宅代理IP免费测试