写在前面的话:

博主也是一个初学者,写的可能也不是很详细或者有错误的,希望大家可以多多指正,多多交流学习经验,不胜感激。

一.如何利用python连接数据库

#此时的db_conn就是数据库的一个连接对象 db_conn = pymysql.Connect( user = "root", password = "",#密码 host = "127.0.0.1",#本机连接 port = 3306,#端口号 database = "blog"#数据库名称 )

我们要使用连接对象获得一个cursor对象,接下来,我们会使用cursor提供的方法来进行工作。

cur=db_conn.cursor() #获取了db_conn的cursor对象,可以利用cursor对象对数据进行增删查改

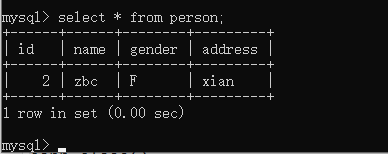

cur.execute('''insert into person (id,name ,gender,address) values (2,'zbc','F','xian')''') #execute后直接加上sql语句的字符串就可以实现对数据库的操作

可能去执行sql语句后发现无法实现对数据的插入,能就忘记对数据进行提交了,下面将介绍一下commit方法。

cur.commit() #据库事务( transaction)是访问并可能操作各种数据项的一个数据库操作序列, #这些操作要么全部执行,要么全部不执行,是一个不可分割的工作单位。 #事务由事务开始与事务结束之间执行的全部数据库操作组成。 #也就是只有提交事务后才会数据库才会实现sql语句的功能

cur.close()#关闭游标 conn.close()#关闭连接

二.实现一个最小的爬虫

爬虫的实现原理:

通过特定的代码,模拟浏览器向服务器向服务器发送各种请求(服务器是无法判断请求的来源的,人类或者机器)。接受响应的HTML页面,对内容进行数据处理(过滤,统计)

最小的爬虫的实现

# encodeing ="utf-8" import urllib.request as req import os #新建目录 os.mkdir("test") url="https://www.17k.com/" #打开网络连接 conn=req.urlopen(url) #读取服务器的反应内容(字节数组),并进行转码 #请求资源->读取内容->编码处理 content=conn.read().decode("utf-8") print(content) #将爬取的数据放入到test目录下的html文件中+ fp =open(file="test/blog.html",mode="w",encoding="utf-8") fp.write(content) fp.close()

“纵使现在满是失败 但是这并不妨碍我继续前进”

神龙|纯净稳定代理IP免费测试>>>>>>>>天启|企业级代理IP免费测试>>>>>>>>IPIPGO|全球住宅代理IP免费测试