从上周起就开始自学大数据相关知识,有人说“要教学生一碗水,自己得有一桶水”,所以教师的知识储备需要跟上时代的脚步不断更新。

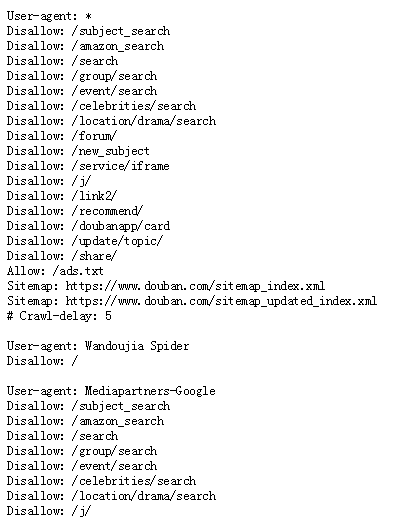

首先,我打开豆瓣网找到了它的robots.txt文件,打开内容如下:

https://www.douban.com/robots.txt

然后根据它的协议构建头文件, user–agent是用户代理的意思,说明什么浏览器或哪些爬虫可以访问本网站,使用*表示任意的访问,Disallow对应的为不允许收录网站的某些目录。然后就可以根据robots.txt文件中允许爬取的方式开始编程爬取数据:

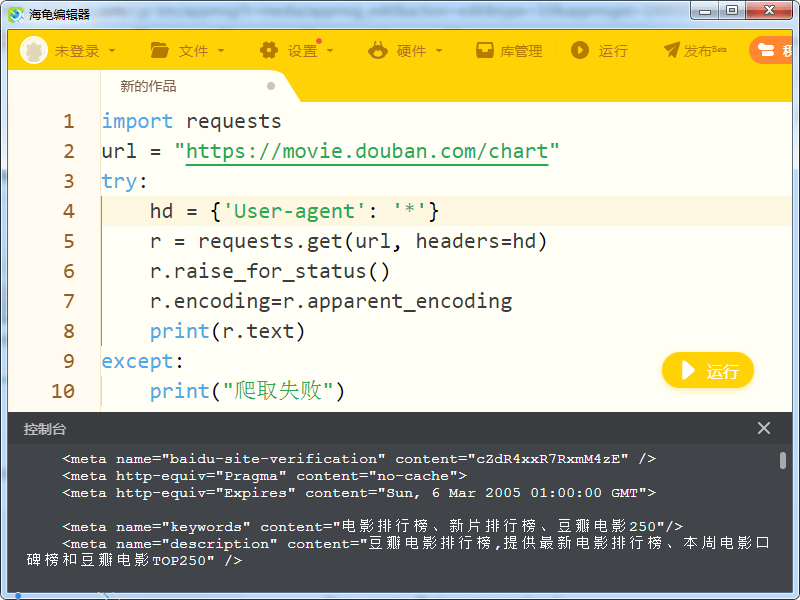

import requests

url ="https://movie.douban.com/chart"try: hd ={'User-agent':'*'} r = requests.get(url, headers=hd) r.raise_for_status() r.encoding=r.apparent_encodingprint(r.text)except:print("爬取失败")

运行后,数据果然被爬取下来了,如下图,是不是很简单?

用同样的方法,只要修改url,并查出robots.txt的内容,修改hd数据,就可以爬取各个不同的网站内容了。

爬虫相关文章

第五章 数据处理和可视化表达的学习 中国爬虫违法违规案例汇总 关于爬虫的合法性 爬虫的基本原理 使用BeautifulSoup解析网页及清洗数据 推荐|Python 爬虫系列教程一爬取批量百度图片 爬虫|python读写csv文件的方法完成生涯规划表

神龙|纯净稳定代理IP免费测试>>>>>>>>天启|企业级代理IP免费测试>>>>>>>>IPIPGO|全球住宅代理IP免费测试