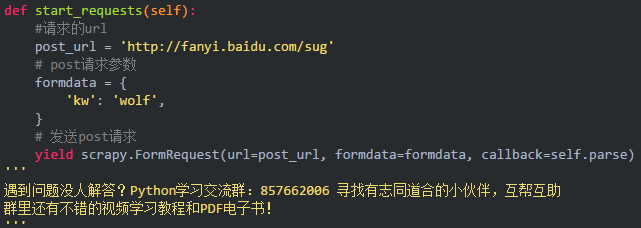

POST请求发送

重写爬虫应用文件中继承Spider类的 类的里面的start_requests(self)这个方法

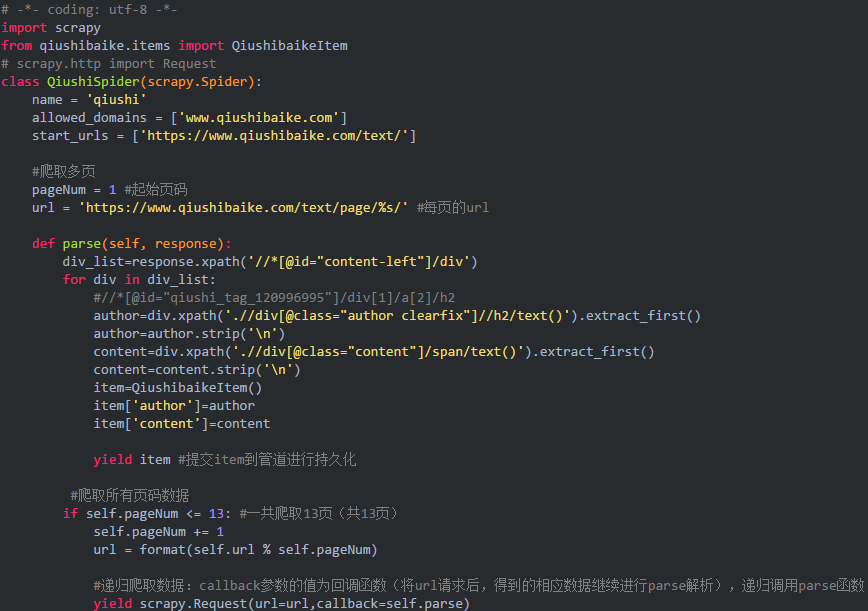

递归爬取

– 递归爬取解析多页页面数据

- 需求:将糗事百科所有页码的作者和段子内容数据进行爬取且持久化存储

- 需求分析:每一个页面对应一个url,则scrapy工程需要对每一个页码对应的url依次发起请求,然后通过对应的解析方法进行作者和段子内容的解析。

- 实现方案:

1.将每一个页码对应的url存放到爬虫文件的起始url列表(start_urls)中。(不推荐)

2.使用Request方法手动发起请求。(推荐)

代码:

神龙|纯净稳定代理IP免费测试>>>>>>>>天启|企业级代理IP免费测试>>>>>>>>IPIPGO|全球住宅代理IP免费测试