深度学习的前提就是海量的数据,在现实生产过程中采集大量的数据是很累时费钱的,这时候就到了爬虫大显身手的时候了。常见的网上爬虫资源方法都很单一,今天我就尝试一下就自己接触的几种方法进行一个简单的总结:

(一)爬虫

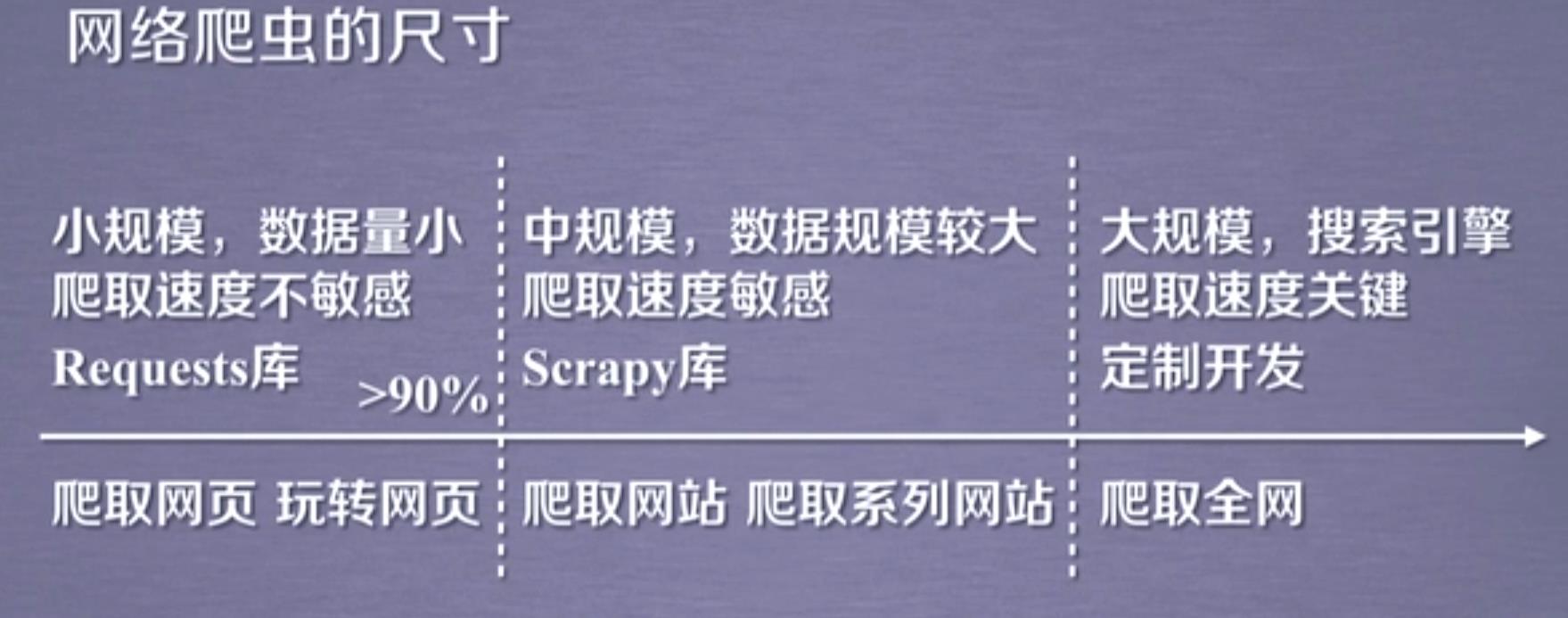

一般根据爬虫内容的大小可以采取以下三种方式:

(1)小规模利用资源库

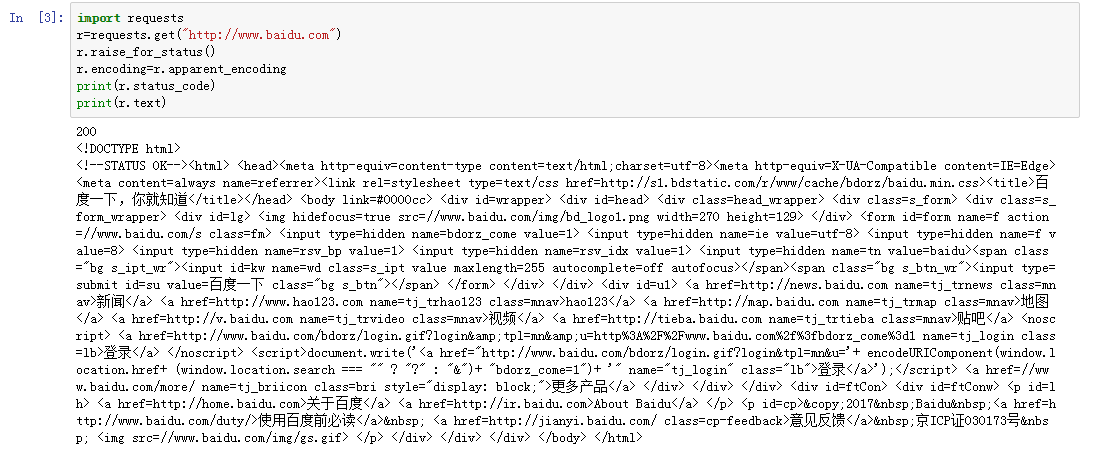

通常利用requests、bs4、re等库来对网页内容解析,然后再爬取想要的资源文件等。

import requests keyword='python' ##搜素Python相关内容 try: r=requests.get("https://www.baidu.com",params=keyword) print(r.status_code) r.raise_for_status print(len(r.text)) except: print("爬取失败!")

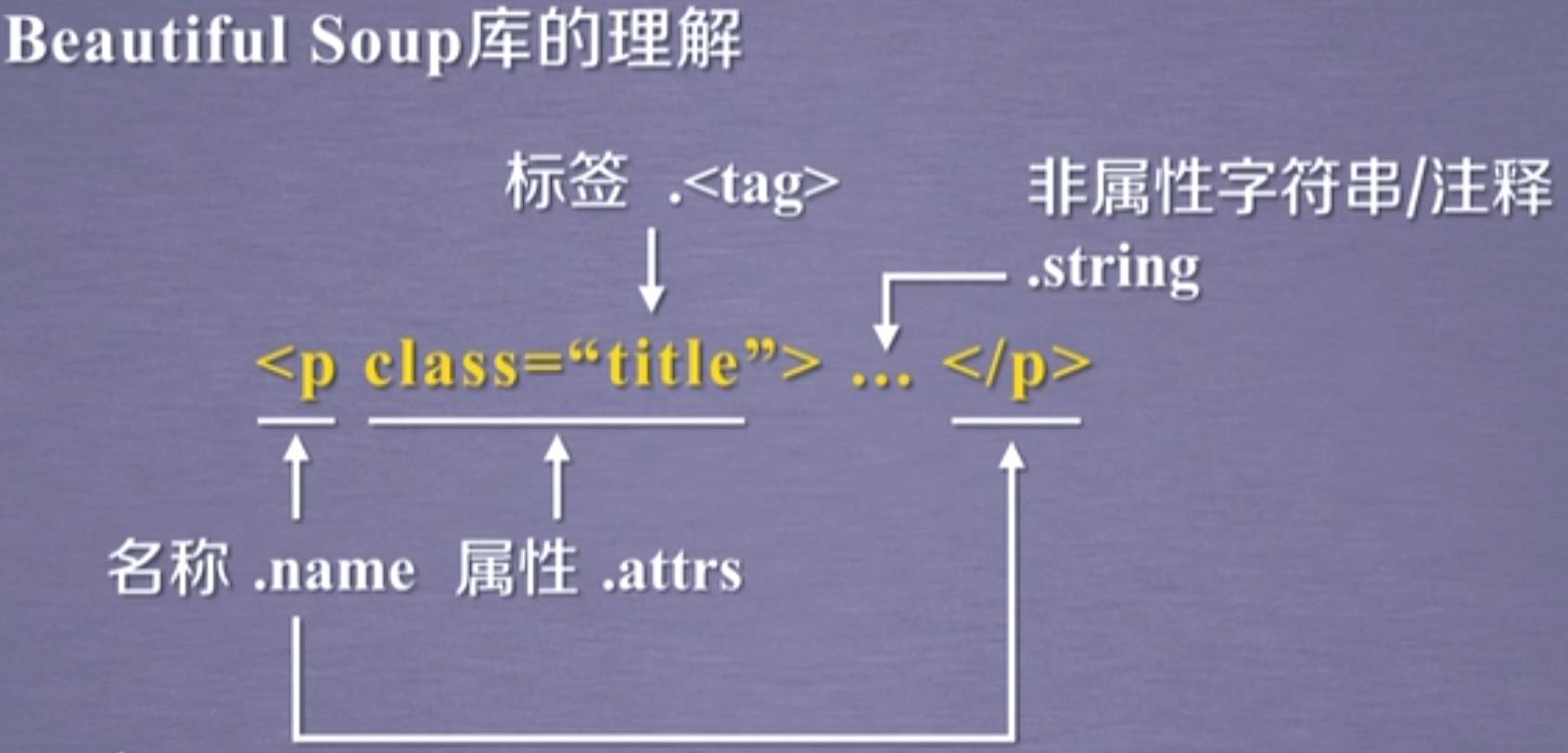

其中对于bs4的beautifulsoup类使用理解如下:

(2)利用爬虫框架

pyspider https://www.jianshu.com/p/39c7371dd6c2

scrapy :https://www.jianshu.com/p/6bc5a4641629

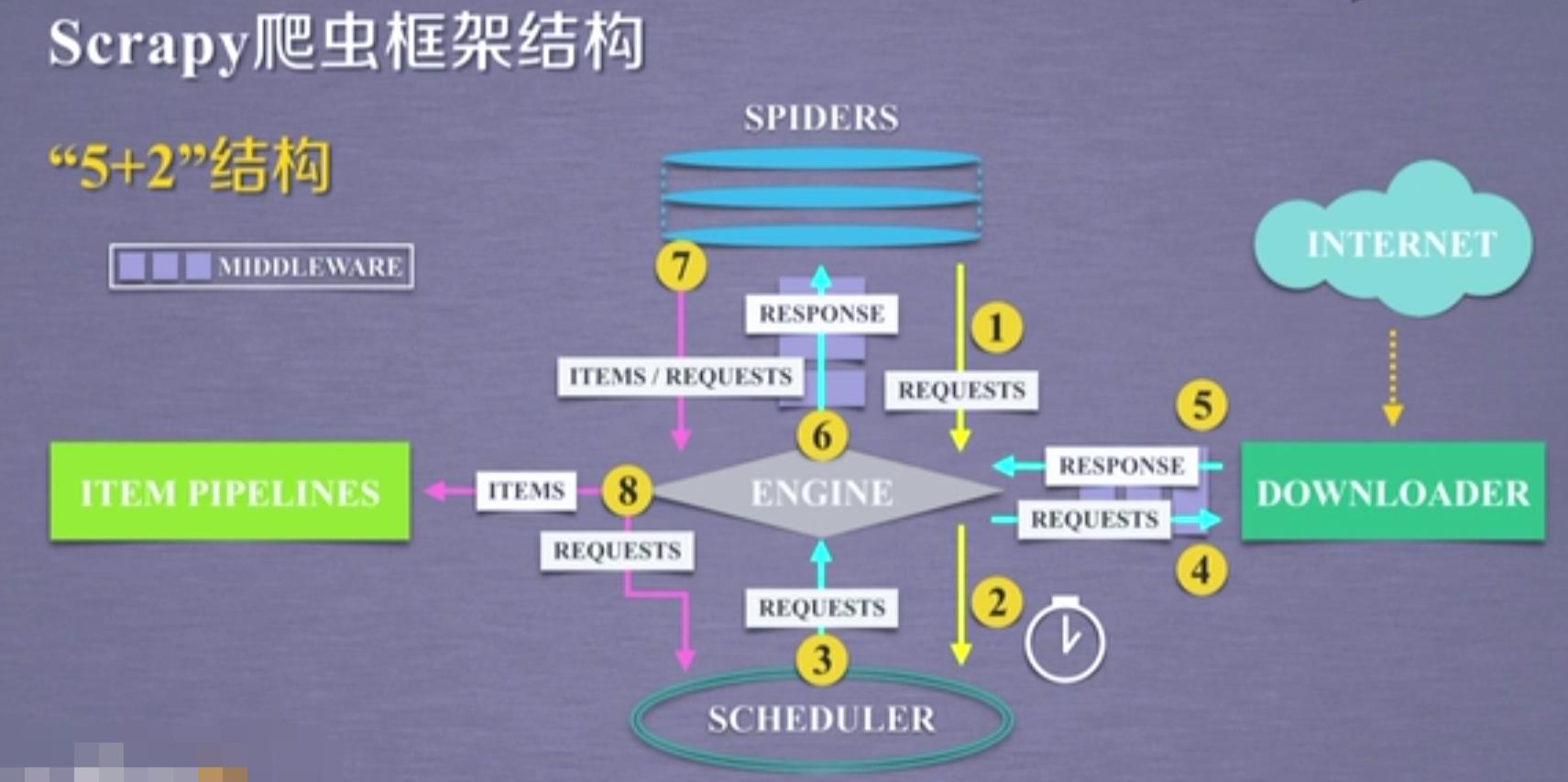

利用scrapy框架来实现网络爬取,其框架如下(5+2):

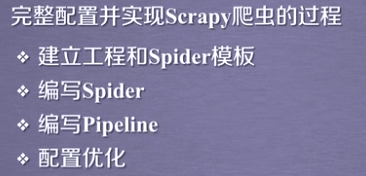

一般需要进行如下操作:

相对于第一种方式而言,

(3)大型的网络爬虫

这种面向互联网所有资源的爬虫,就像Google或者百度一样做搜索引擎,这样的化一般需要进行专门的定制开发,这里就不做赘述。。。

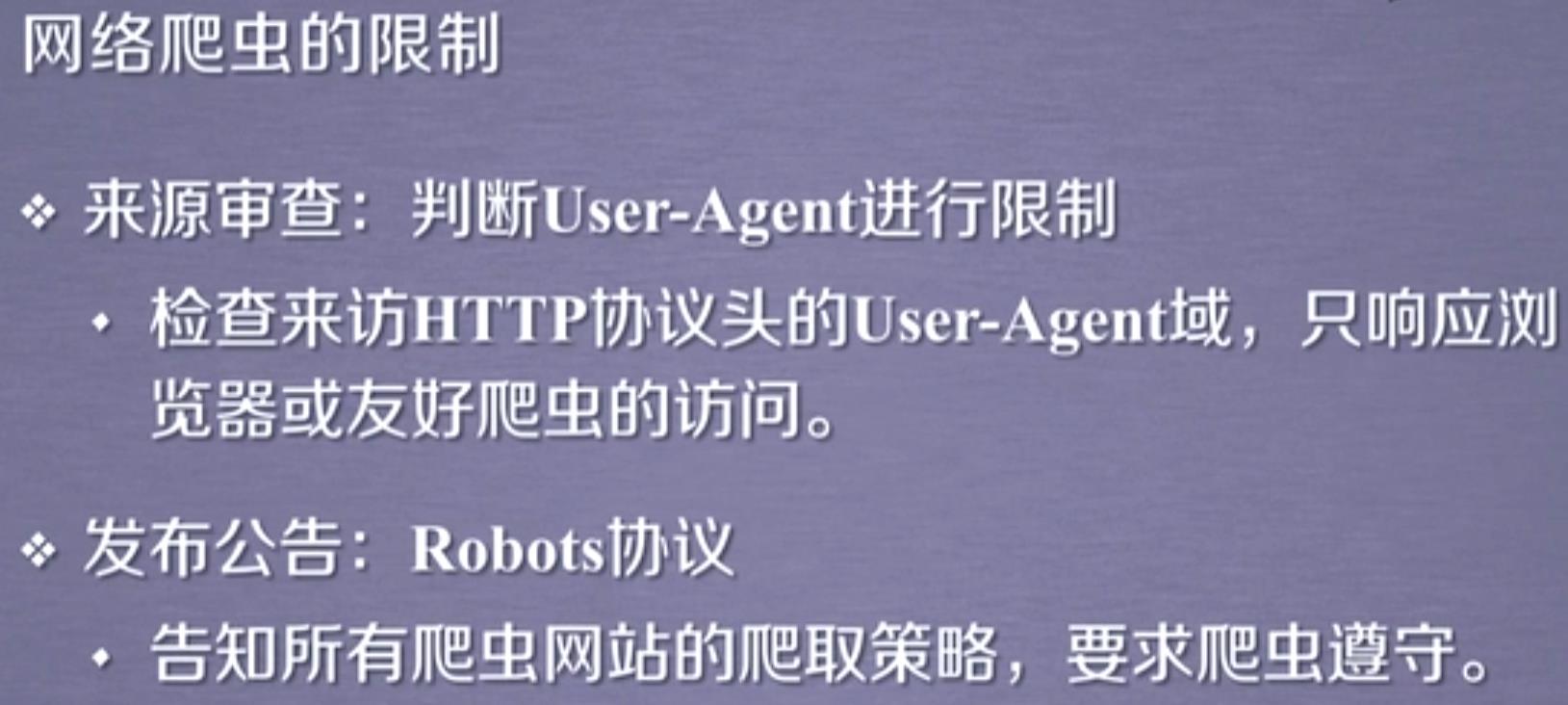

(二)反爬虫

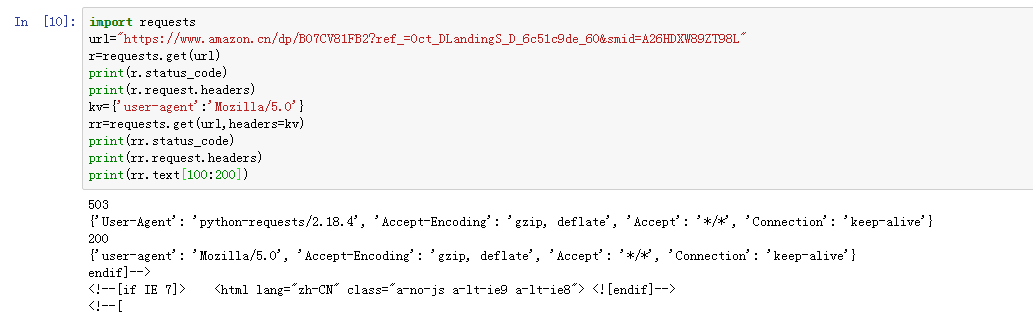

矛与盾自古就是相生相克的,想要合理利用爬虫就需要同时对反爬虫机制进行一定的了解,知己知彼百战百胜嘛!下面看一些例子:

(1)没有限制的

(2)有限制

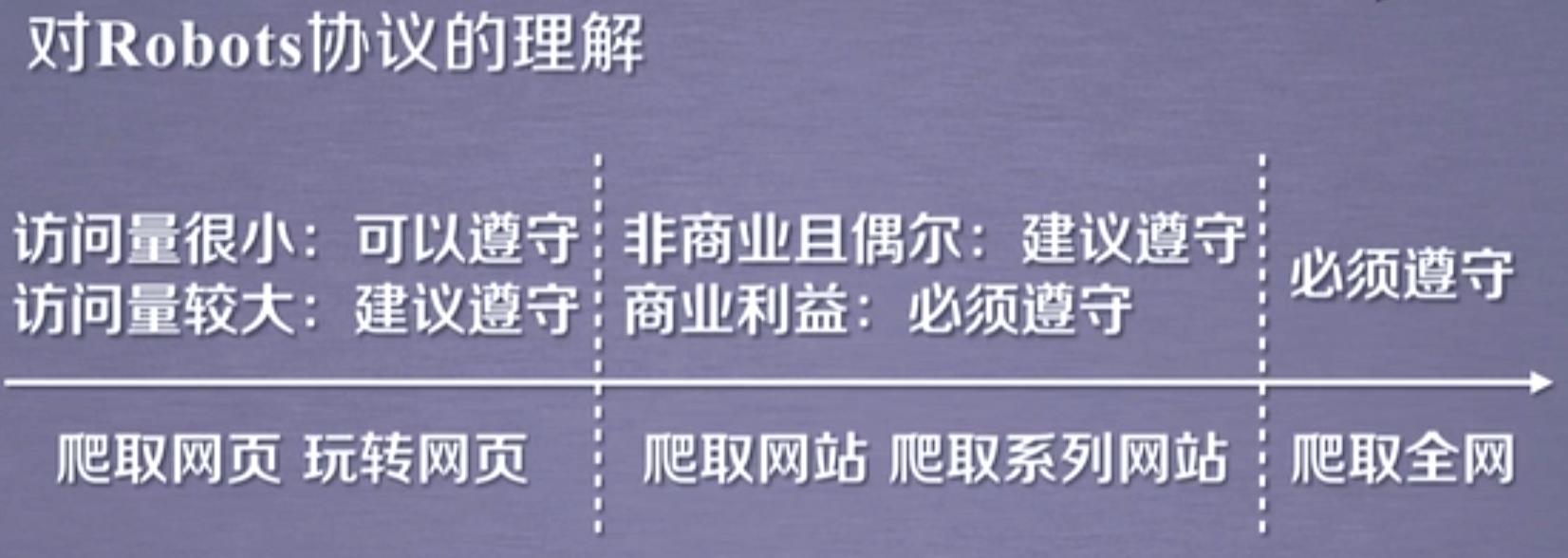

总之,爬虫涉及到web资源的索取以及一些法律问题(敏感信息),我们需要谨慎对待

理性爬虫,和谐生活!!!

神龙|纯净稳定代理IP免费测试>>>>>>>>天启|企业级代理IP免费测试>>>>>>>>IPIPGO|全球住宅代理IP免费测试