一、爬虫是什么?

爬虫也叫网页蜘蛛,网络机器人,就是模拟客户端发送网络请求,获取请求对应的响应,一种按照一定规则,自动抓取互联网信息的程序。

即:通过模拟真实用户,向服务器(发送请求)-》获取响应(爬取到的服务器数据)-》对数据进行清洗操作-》数据保存操作

1. 反爬的重点:在于是否能够获取真实的数据

服务器会识别不是一个真实的用户,那么就不会返回数据,这种行为就叫做反爬(服务器对爬虫)

2. 被反爬之后怎么操作呢?

需要伪装成一个真实的用户,发送请求,这种行为就叫做反反爬(爬虫对服务器)

3. 爬虫本质:

可见皆可爬

4. 爬虫名词解释:

(1)爬虫:模拟客户端访问,抓取数据

(2)反爬:保护重要数据,阻止恶意网络攻击

(3)反反爬:针对反爬做的措施

5. 被反爬之后怎么解决呢?(反反爬)

ua反爬:ua(useragent) 用户身份 服务端会根据用户的请求次数以及请求的身份进行反爬

ua反反爬: 换用不同的ua请求次数降低 时间延时

反爬ip: 对ip访问服务器的次数做记录,达到一定次数,不返回数据

反反爬:换不同的ip

除以上两种反爬方法外还有cookie反爬,后面再进行详细了解

二、为什么要学习爬虫呢?

互联网大数据时代,网络上存在海量的信息,但大多数时候都是无效的垃圾信息。那么我们只需要提取对自己有用的信息,即从海量的信息中获取对自己有用的信息,这个过程是相当的庞大的工程,单单靠人工是无法完成的,那么这时候网络蜘蛛的出现无疑是给我们带来了便捷。通过一定条件的筛选把海量的信息中收集相关内容的信息,再对信息进行分析整合最终得到需要的数据。

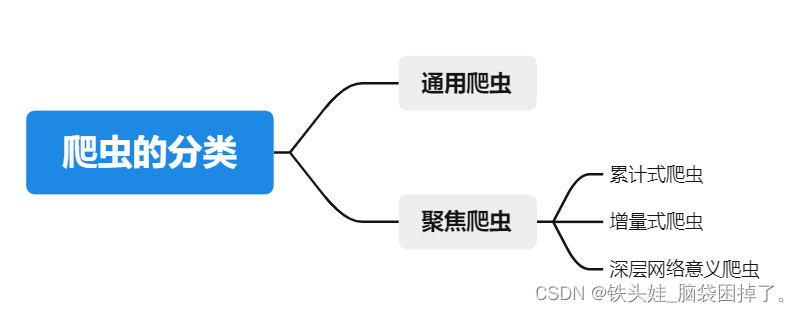

三、爬虫的分类

1、通用爬虫:通常指搜索引擎和大型web服务提供商的爬虫(比如:百度https://www.baidu.com)

- 什么数据都爬

2、聚焦爬虫:针对特定网站的爬虫,定向的获取某方面数据的爬虫

- 针对性的爬取数据,定制专门爬取某网页数据的爬虫程序

(1)累计式爬虫:从开始到结束,一直爬取,中间做到去重的操作(一次性的 内存释放以后得重新爬取;再去运行会重复爬取)

(2)增量式爬虫:从开始到结束,一直爬取,中间做到去重的操作(非一次的 再次爬取 会读取本地已经爬取下来的数据 对其进行判断有就爬取,没有就爬取)

(3)深层网络意义爬虫:不能通过静态链接获取的,隐藏在搜索表单后的,只有用户提交一些关键词才能获得的web页面(会对请求服务器所传递的表单进行 参数加密)

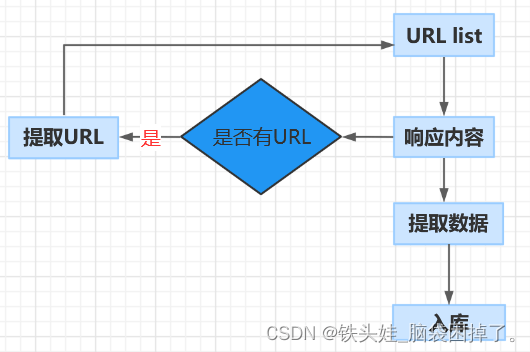

四、爬虫的流程

聚焦爬虫的工作原理:

向一个url list发送请求,获取响应内容,提取数据,最后保存数据,保存数据有两种方式:本地和入库,如果响应内容有URL,提取URL再向url list发送请求再次获取响应内容,提取数据,保存数据。

详细步骤:

确认url 数据包 图片链接 视频连接

1. 发送请求 获取响应

2. 清洗数据 -》 提取url -》 再次发送请求

3. 保存数据

注意:爬取的音视频、图片不需要进行数据清洗,直接保存。

神龙|纯净稳定代理IP免费测试>>>>>>>>天启|企业级代理IP免费测试>>>>>>>>IPIPGO|全球住宅代理IP免费测试