平时没事的时候,很多人喜欢把自己的生活或者工作心得分享到博客上,也是互相交流的一种方法。不过想大量的看一些博客,在获取的时候就容易出现乱码的问题,相信这点很多小伙伴们都遇到了。今天小编就带来selenium的方法帮助大家解决python爬虫乱码问题。

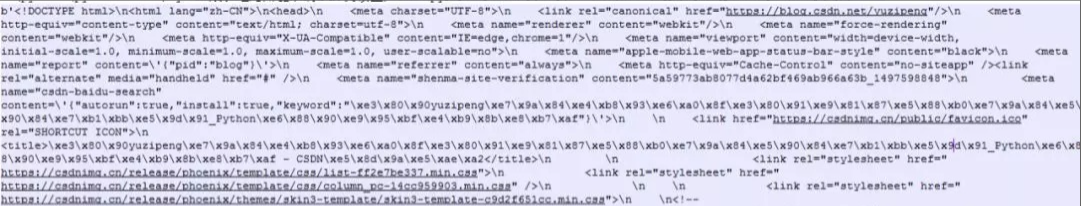

在用requests库对博客进行爬取时,发现乱码报错,如下图所示:

网上查找了一些方法,以为是遇到了网站加密处理。后来发现 通过F12还 是能获取网页的元素,那么有什么办法能规避乱码问题呢?答案是:用selenium.

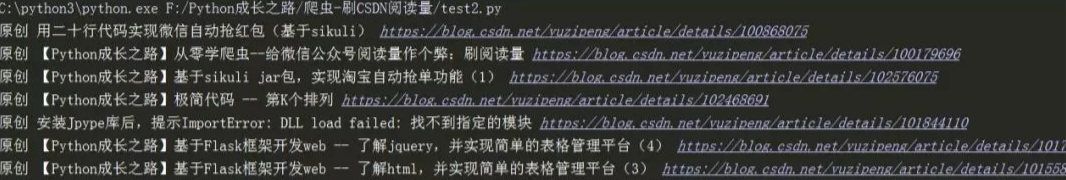

效果如下

代码

# coding=utf-8

# @Auther : "鹏哥贼优秀"

# @Date : 2019/10/16

# @Software : PyCharm

from selenium import webdriver

url = 'https://blog.csdn.net/yuzipeng'

driver = webdriver.Chrome("F:\\Python成长之路\\chromedriver.exe")

driver.get(url)

urls = driver.find_elements_by_xpath('//div[@class="article-item-box csdn-tracking-statistics"]')

blogurl = ['https://blog.csdn.net/yuzipeng/article/details/' + url.get_attribute('data-articleid') for url in urls]

titles = driver.find_elements_by_xpath('//div[@class="article-item-box csdn-tracking-statistics"]/h4/a')

blogtitle = [title.text for title in titles]

myblog = {k:v for k,v in zip(blogtitle,blogurl)}

for k,v in myblog.items():

print(k,v)

driver.close()

在python爬虫中有不少的方法可以解决乱码问题,小伙伴们跟selenium比比,到底哪个好用呢?

神龙|纯净稳定代理IP免费测试>>>>>>>>天启|企业级代理IP免费测试>>>>>>>>IPIPGO|全球住宅代理IP免费测试